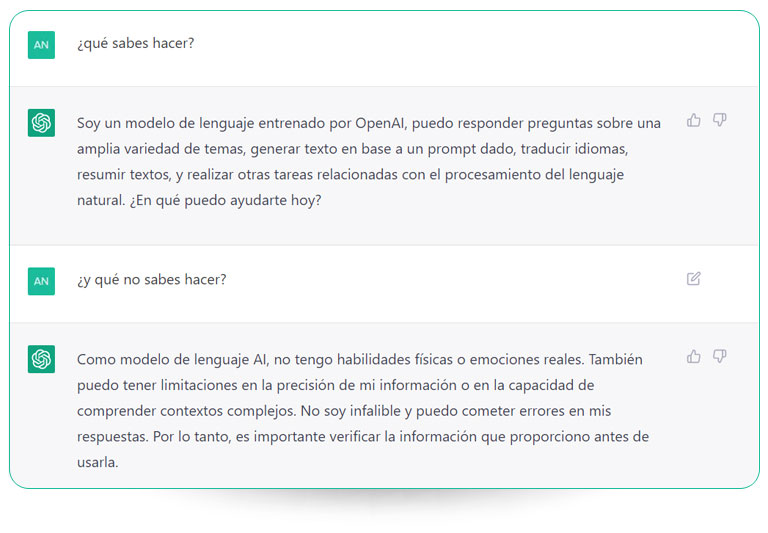

Si os dijéramos que muchas de las partes de este post están escritas por ChatGPT, nos creeríais. Esta Inteligencia Artificial ya nos asiste en la redacción de todo tipo de textos y nos contesta a preguntas de manera muy natural y quizás con demasiada seguridad. Sin duda, ya ha cambiado la forma en la que interactuamos con las máquinas y poco a poco le damos más uso en tareas cotidianas y profesionales.

Además, este modelo de lenguaje multilingüe desarrollado por Open AI demuestra funcionar muy bien en español, suponiendo un gran avance en el ámbito del Procesamiento del Lenguaje Natural (PLN) en nuestro idioma. Sin embargo, a la vez que nos sorprende, también vamos descubriendo algunas de sus limitaciones.

ChatGPT suele quedarse en un nivel superficial y falla cuando le hacemos preguntas más específicas o le pedimos cosas que requieren un conocimiento mayor sobre un ámbito o disciplina. En este post, os contamos hasta qué punto es aplicable ChatGPT y cómo, desde la experiencia del IIC, podemos adaptar los modelos de lenguaje a tareas y dominios concretos para que sean más eficaces.

Posibilidades y limitaciones de ChatGPT

Cuando utilizamos ChatGPT, nos encontramos ante lo más de lo más en generación del lenguaje. Su punto fuerte es la capacidad que tiene de resumir y sintetizar la información que tenemos disponible online. Además, este modelo de lenguaje entrenado para mantener conversaciones sobre cualquier tema está consiguiendo democratizar algunos de los usos positivos de la Inteligencia Artificial, como la posibilidad de automatizar ciertas tareas o de utilizarlo como asistente en trabajos más creativos.

A partir de una gran cantidad de textos de Internet, ChatGPT ha aprendido a predecir qué palabras es más probable que sigan a una secuencia dada. Es más, a diferencia de otros modelos disponibles, no solo ha aprendido cómo se estructura el lenguaje, sino que un equipo humano le ha indicado después qué conversaciones y respuestas nos encajan más como humanos, de ahí su naturalidad.

No obstante, es importante considerar que no entiende las palabras que “aprende” o el conocimiento que genera, solo sabe completar frases de forma probabilística. Los expertos y la IA misma nos invitan a ser críticos con lo que responde, que es más dudoso cuanto más específicas son las preguntas y las tareas que le planteamos. En estos casos, como puede ser resumir un texto legal o pedirle un código de programación complejo, funcionan mejor los modelos de lenguaje específicamente entrenados para ello.

No obstante, es importante considerar que no entiende las palabras que “aprende” o el conocimiento que genera, solo sabe completar frases de forma probabilística. Los expertos y la IA misma nos invitan a ser críticos con lo que responde, que es más dudoso cuanto más específicas son las preguntas y las tareas que le planteamos. En estos casos, como puede ser resumir un texto legal o pedirle un código de programación complejo, funcionan mejor los modelos de lenguaje específicamente entrenados para ello.

Aplicación de los modelos de lenguaje

Es en 2019 cuando realmente podemos empezar a hablar de modelos de lenguaje en español, con el lanzamiento de BETO desde la Universidad de Chile. Es cierto que las grandes tecnológicas siguen liderando el desarrollo de herramientas y recursos de PLN en inglés, pero quizás por esto, en nuestro país esta revolución va muy unida a la aplicación y utilidad real de estos modelos. Instituciones y empresas españolas hemos puesto el foco, más que en la cantidad, en la calidad de esos recursos y en la adaptación de los modelos a tareas o problemas determinados con un corpus y un entrenamiento específicos.

Normalmente son los centros de investigación los que se ocupan del desarrollo de los modelos de lenguaje, y las entidades privadas y consultoras las encargadas de adaptarlos y ponerlos en práctica en contextos y negocios concretos. En el IIC, por nuestra naturaleza, somos capaces de abordar ambos procesos: el PLN sigue protagonizando una de nuestras líneas de investigación, pero también trabajamos en su aplicabilidad en diferentes ámbitos.

En este camino, ya hemos desarrollado nuestro propio modelo de lenguaje (RigoBERTa), dotando de calidad a todas las piezas que lo componen con un equipo humano multidisciplinar. Pero más allá, lo que marca la diferencia en PLN es adaptar los modelos a medida de las necesidades de empresas e instituciones de todo tipo. Y no solo se trata de ajustarlos a la tarea que se quiere automatizar o mejorar, sino también al lenguaje y terminología que se maneja en ese ámbito en concreto, lo que se conoce como adaptación a dominio.

Adaptación a dominio de los modelos de lenguaje

Normalmente, los modelos de lenguaje generales, como GPT-3, sirven como base para automatizar tareas concretas de Procesamiento del Lenguaje (PLN), ya sea la clasificación de textos o la traducción automática, o para desarrollar aplicaciones con nombre propio, como ChatGPT. Esto se consigue re-entrenando los modelos con un corpus o conjunto de textos que refleje la tarea objetivo.

No obstante, estos modelos del lenguaje ya adaptados pueden no funcionar tan eficazmente cuando se encuentran con los términos empleados en sectores especializados, como el médico, el financiero o el legal. De ahí el interés por añadir otro paso más en ese reajuste del modelo: la adaptación a dominio.

En el IIC, antepusimos este nuevo paso al denominado ajuste fino al problema. Y funcionó, por ejemplo, con el dominio legal. En este caso, partimos del modelo del lenguaje general del español BETO, que adaptamos con un corpus legal-administrativo que reflejara la terminología y jerga de este ámbito. Esa es la clave: el trabajo humano con las fuentes de datos y los corpus para que estos sean representativos del lenguaje o de la tarea a automatizar.

Así pues, esta metodología nos permite explotar los recursos disponibles y dar a los modelos de lenguaje generales una utilidad más concreta, pudiendo conseguir un sistema más adaptado y fiable que ChatGPT. De hecho, esto se ve facilitado con modelos más bien pequeños como nuestra RigoBERTa, que ya tiene una nueva versión.

Modelo de lenguaje del IIC: RigoBERTa 1.1.

Como hemos visto, los modelos de lenguaje generales están entrenados para aprender la estructura del lenguaje en uno o varios idiomas, con el fin de que después sirvan como base y se adapten más fácilmente a tareas concretas de PLN o a diferentes dominios.

En pleno boom del PLN en español, en el IIC quisimos aportar también a ese avance con RigoBERTa, un modelo de lenguaje que desarrollamos con más y mejores datos y mejor arquitectura que los que estaban disponibles en aquel momento, y ya con la idea de esa adaptación a dominio posterior. Recientemente hemos lanzado una nueva versión: RigoBERTa 1.1, entrenada con mayor cantidad de datos, y que supone una mejora en calidad sobre el modelo RigoBERTa original.

En pleno boom del PLN en español, en el IIC quisimos aportar también a ese avance con RigoBERTa, un modelo de lenguaje que desarrollamos con más y mejores datos y mejor arquitectura que los que estaban disponibles en aquel momento, y ya con la idea de esa adaptación a dominio posterior. Recientemente hemos lanzado una nueva versión: RigoBERTa 1.1, entrenada con mayor cantidad de datos, y que supone una mejora en calidad sobre el modelo RigoBERTa original.

La ventaja de estos modelos de lenguaje, pequeños en comparación con GPT-3, es que son más fácilmente adaptables y pueden llegar a ser más eficientes. De hecho, es posible instalarlos en la infraestructura de la entidad que lo vaya a utilizar. Además de trabajar con nuestro modelo de lenguaje propio, en el IIC también adaptamos modelos opensource, que enriquecemos con recursos de calidad de la mano de un equipo multidisiciplinar.

Equipo multidisciplinar de lingüistas computacionales y data scientists

El éxito de ChatGPT depende sin duda del equipo humano detrás de la aplicación que, entre otras cosas, se ha ocupado de simular y evaluar las conversaciones con la que la máquina ha aprendido a ser tan natural en su expresión. Y es que, además de trabajar la parte computacional y técnica de la Inteligencia Artificial, los proyectos de PLN requieren aplicar conocimientos lingüísticos.

En el IIC contamos con un equipo multidisciplinar propio, compuesto por data scientists especializados en PLN y por lingüistas computacionales que se encargan principalmente de crear y anotar los corpus con los que se entrenan los modelos y de validar los resultados. Este trabajo conjunto es la clave para desarrollar y mejorar las piezas clave de los sistemas y herramientas de PLN.

Con esto, cabe destacar lo necesaria que es la supervisión humana en el desarrollo de los modelos de lenguaje, pero también a la hora de ponerlos en práctica y decidir qué uso le damos a la Inteligencia Artificial. Aunque ChatGPT nos asombre, existen proyectos más pequeños y menos mediáticos que son más efectivos en cuanto a atacar una tarea o problema concreto, acercándonos a la utilidad real del PLN.