Una nueva tecnología para mejorar las aplicaciones de Procesamiento del Lenguaje Natural

En el IIC desarrollamos un modelo de comprensión del lenguaje propio y lo adaptamos a distintos dominios del lenguaje y tareas de PLN.

¿Qué es RigoBERTa?

RigoBERTa es el modelo de lenguaje en español del IIC y actualmente uno de los modelos de comprensión del lenguaje del estado del arte en nuestro idioma.

RigoBERTa está entrenado para la comprensión general de nuestro idioma y cuenta con la posibilidad de adaptarse a diferentes dominios del lenguaje (legal, salud, etc.) para mejorar las aplicaciones del Procesamiento del Lenguaje Natural (PLN) en ámbitos específicos.

A diferencia de los modelos generativos, RigoBERTa se especializa en tareas de análisis y comprensión (Natural Language Understanding, NLU): clasificación de textos, detección y extracción de entidades, análisis del sentimiento, etc.

En el IIC, llevamos tiempo trabajando en modelos de lenguaje, en el marco de un proyecto de investigación que tenía como principal objetivo desarrollar un modelo de lenguaje propio. RigoBERTa es el resultado de nuestra labor como centro de investigación e innovación, junto con el apoyo al grupo de trabajo de nuestra Cátedra UAM-IIC de Lingüística Computacional.

Los modelos del lenguaje son redes neuronales artificiales de gran tamaño, capaces de analizar ingentes volúmenes de texto escrito para aprender la estructura con la que se presentan las palabras de un determinado idioma.

Con este pre-entrenamiento, se convierten en modelos generales que se pueden re-entrenar con fines y corpus más específicos, ya sea para resolver una tarea concreta de PLN o para adaptarlo al lenguaje y terminología de un dominio.

Esta tecnología está mucho más desarrollada en inglés, con modelos conocidos como BERT o GPT-3. En español no existen actualmente tantos recursos, por lo que nuestro modelo de lenguaje en español RigoBERTa surge para contribuir al desarrollo del PLN en nuestro idioma.

¿Cómo funciona un modelo de lenguaje general?

Los modelos del lenguaje son la base de la mayoría de sistemas y aplicaciones modernas de Procesamiento del Lenguaje Natural (PLN).

Si quieres conocer el modelo de lenguaje español RigoBERTa, no dudes en escribirnos.

Potencial y aplicaciones de RigoBERTa

En el IIC, investigamos el desarrollo del PLN y los modelos de lenguaje, pero también trabajamos para aplicarlos en diferentes ámbitos. Tenemos una metodología propia de adaptación en dos pasos, que nos permite dar a los modelos de lenguaje generales una utilidad más concreta.

ADAPTACIÓN A LAS TAREAS DE PLN

Los modelos de lenguaje se pueden aplicar para resolver eficazmente distintas tareas de PLN, desde la clasificación de documentos hasta la respuesta automática a preguntas.

ADAPTACIÓN A DOMINIOS DEL LENGUAJE

Adaptación a dominios del lenguaje, a través de corpus específicos y representativos y con el fin de que reconozcan la terminología específica de distintos ámbitos.

RigoBERTa está pensado para aplicarse a un nivel productivo o empresarial y no para utilizarse a nivel usuario como la mayoría de modelos generativos. Más que una aplicación general como los chats que responden a preguntas de todo tipo, es un modelo de lenguaje que se adapta a casos concretos, resultando así más eficiente.

Actualmente ya está disponible la versión RigoBERTa 2.0, entrenada con mayor cantidad de datos y que supone una mejora en calidad sobre el modelo RigoBERTa original. Desde el IIC, ya estamos aplicando RigoBERTa 2.0 en distintos ámbitos, desplegado e integrado en la propia infraestructura de nuestros clientes.

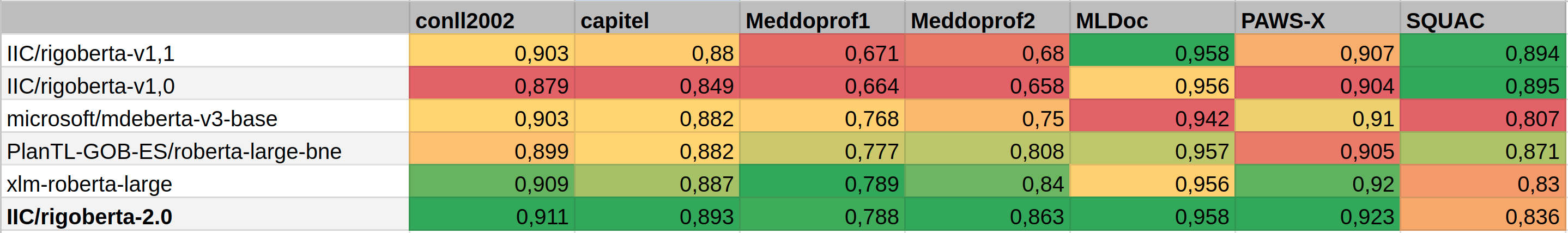

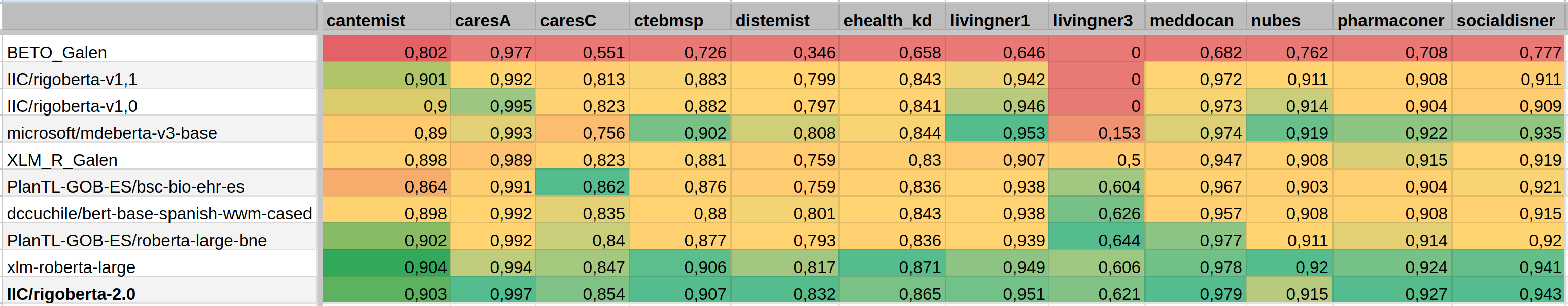

Hemos comparado su rendimiento frente a otros modelos de lenguaje disponibles en nuestro idioma (MarIA-large, BETO, etc.) en un benchmark con 19 datasets que abarcan tareas de respuesta extractiva a preguntas, detección de entidades y clasificación de textos en todas sus formas. Además, uno de los tres experimentos se especializó en el dominio biomédico, como campo de interés para el IIC.

Desarrollo y resultados de RigoBERTa 2.0

El equipo multidisciplinar del IIC, formado sobre todo por data scientists expertos en PLN y lingüistas computacionales, se encargó del desarrollo y entrenamiento del modelo de lenguaje en español RigoBERTa y lo mantiene actualizado con las últimas investigaciones y técnicas.

RigoBERTa 2.0 frente a otros modelos de lenguaje en español en un benchmark con 19 datasets

Los resultados muestran que RigoBERTa 2.0 supera al resto de modelos en la mayoría de las tareas evaluadas, logrando mejoras significativas en la detección de entidades y en la clasificación de textos. Esto demuestra su capacidad para comprender y contextualizar el lenguaje de manera más efectiva que sus competidores. Además, las primeras versiones de RigoBERTa mantienen su ventaja competitiva en las tareas de respuesta extractiva a preguntas, lo que lo convierte en un modelo complementario.

· Benchmark general ·

· Benchmark en dominio biomédico ·

RigoBERTa 2.0 es la última versión del modelo de lenguaje del IIC, en el que empezamos a trabajar en 2020. Forma parte de la línea de modelos y recursos que hemos creado para desarrollar y adaptar distintas soluciones de PLN en español.

RigoBERTa

Modelos del lenguaje fundacionales de comprensión del español.

RigoCORPUS

Gran corpus curado para entrenamiento de modelos fundacionales.

RigoCHAT

Modelos de lenguaje generativos en español.

RigoExtensions

Adaptaciones de RigoBERTa a dominios o casos de uso concretos y modelos de embeddings.