Uno de los principales retos que afrontan actualmente las organizaciones es la interoperabilidad entre sistemas y fuentes de datos. En la práctica, la información empresarial se encuentra dispersa en múltiples entornos: desde plataformas de gestión, hojas de cálculo, bases de datos de diferentes naturalezas hasta, incluso, correos electrónicos.

Cada uno de estos sistemas custodia fragmentos relevantes del conocimiento de la compañía, pero no suelen estar conectados de manera fluida. Además, la información disponible se actualiza de forma constante, lo que dificulta contar con versiones consistentes. El resultado es un conjunto de silos de información que dificultan una visión unificada y actualizada del negocio.

Cada uno de estos sistemas custodia fragmentos relevantes del conocimiento de la compañía, pero no suelen estar conectados de manera fluida. Además, la información disponible se actualiza de forma constante, lo que dificulta contar con versiones consistentes. El resultado es un conjunto de silos de información que dificultan una visión unificada y actualizada del negocio.

Tradicionalmente, la forma de resolver este problema ha sido a través de integraciones a medida. Sin embargo, este enfoque conlleva altos costes, largos tiempos de desarrollo y una gran fragilidad. Esta situación genera procesos poco ágiles, ralentiza la innovación y deriva en decisiones tomadas a partir de información incompleta o desactualizada. Además, obliga a los equipos a dedicar gran cantidad de tiempo a tareas manuales.

En definitiva, lo que falta es una forma estándar, flexible y segura de conectar fuentes y herramientas diversas. Existen estrategias consolidadas como la construcción de Data Lakes o la apificación para formar un Data Mesh de servicios de datos distribuidos, que han supuesto avances importantes en la integración y gestión del dato. Sin embargo, estas aproximaciones suelen ser costosas de implementar y mantener, son muy sensibles a la calidad que tengan los datos y no siempre resuelven la complejidad de orquestar procesos dinámicos entre sistemas heterogéneos. Es más, construir un Data Lake obliga a definir esquemas comunes de datos y a planificar de antemano qué tipo de integraciones entre silos se desean y la apificación requiere implementar conectores entre sistemas, sin la existencia de un estándar a la hora de implementar y descubrir estas API. En este contexto se abre la puerta a soluciones basadas en agentes inteligentes con LLM: orquestadores capaces de navegar de manera autónoma por distintos entornos y de hacer que los datos fluyan entre ellos.

Plataforma de agentes inteligentes basados en LLM

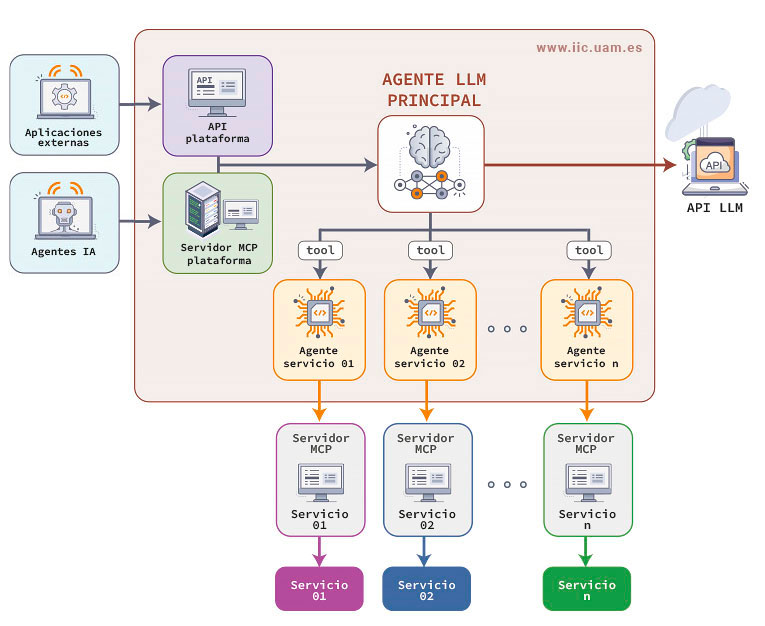

En el Instituto de Ingeniería del Conocimiento (IIC) hemos diseñado una plataforma de agentes inteligentes basados en LLM, que integran de datos y servicios basada en agentes de inteligencia artificial (IA) y que actúa como una capa de abstracción y orquestación entre diferentes servicios y sistemas distribuidos desde una interfaz única.

En el Instituto de Ingeniería del Conocimiento (IIC) hemos diseñado una plataforma de agentes inteligentes basados en LLM, que integran de datos y servicios basada en agentes de inteligencia artificial (IA) y que actúa como una capa de abstracción y orquestación entre diferentes servicios y sistemas distribuidos desde una interfaz única.

Este sistema inteligente unifica el acceso y la consulta de datos provenientes de servicios aislados o con integraciones complejas, ofreciendo una forma rápida y simple de utilizarlos.

Para entenderlo veamos un ejemplo muy sencillo. Un empleado de una empresa sin conocimientos en bases de datos necesita respuesta para la siguiente pregunta para tomar una decisión importante:

“¿Qué proyectos acumulan más retrasos y cuál es la carga de trabajo de los equipos asignados a ellos?”

Responder a esta pregunta implicaría acceder a la base de datos de gestión de proyectos y al sistema de Recursos Humanos.

Supongamos que la primera es una base de datos de tipo NoSQL y el segundo es un sistema que gestiona los datos de los equipos en archivos de tipo xlsx. Este empleado no puede hacerlo por sí mismo porque no conoce las fuentes y, por lo tanto, necesitaría, posiblemente, ayuda de una o más personas para encontrar la solución a su problema.

Sin embargo, nuestra plataforma de agentes inteligentes basados en LLM ofrece una alternativa mucho más rápida. El empleado puede simplemente escribir su pregunta en la interfaz y obtener la respuesta que busca en cuestión de segundos. En el siguiente diagrama, se muestran todos los pasos que se han seguido para dar las respuestas en segundos.

Un agente orquestador basado en LLM con acceso, a su vez, a tantos agentes (que llamaremos subagentes) como fuentes distintas se deseen conectar, ha interpretado la consulta, ha identificado qué datos se requieren para responder y ha llamado a los subagentes correspondientes en busca de la información. Los subagentes, a través del estándar Model Context Protocol (MCP) para conectar agentes basados en LLM con herramientas, datos y sistemas externos de manera estructurada y segura, han recuperado los datos solicitados y mediante un sistema propiedad del IIC, se ha devuelto la información al agente orquestador que a través de su LLM ha construido la respuesta final.

La capacidad de los agentes LLM para comprender el lenguaje natural, traducirlo a consultas estructuradas y, al mismo tiempo, aprovechar diferentes herramientas tecnológicas, abre la posibilidad de enfrentar el desafío de los silos de datos desde una perspectiva novedosa, permitiendo no solo integrarlos y hacerlos accesibles, sino también generar un mayor valor a partir de la información dispersa dentro de una organización.

Capacidades de los agentes inteligentes basado en LLM

La plataforma de agentes inteligentes basados en LLM ofrece mucho más que una respuesta a una pregunta:

- Interfaz de usuario. Proporciona un único punto de acceso para realizar consultas cruzadas entre múltiples servicios.

- Orquestación inteligente de respuestas. Recibe una consulta compleja y la descompone automáticamente en subconsultas distribuidas, llamando a cada servicio correspondiente y unificando las respuestas mediante un sistema propio del IIC.

- Enriquecimiento de resultados mediante IA. El agente puede aplicar lógica de negocio y enriquecimiento de datos antes de devolver la respuesta final.

- Compatibilidad multi-entorno. Opera de forma transparente sobre entornos on-premise, cloud o híbridos, gestionando las restricciones de cada uno.

- Auditoría y trazabilidad. Cada interacción queda registrada y trazada, cumpliendo con los requisitos normativos y de control interno.

- Escalabilidad y modularidad. Metodología escalable y modular, tanto por el lado del software como por el lado del mantenimiento y los responsables de cada sistema.

- Robustez. El sistema incorpora varios mecanismos para evitar modos de fallo.

Evaluación y análisis de calidad de la plataforma de agentes inteligentes

Para evaluar el funcionamiento de la plataforma de agentes inteligentes basados en LLM, ha sido clave diseñar estrategias específicas de validación que permitan medir su rendimiento en distintos escenarios. Se han creado conjuntos de test con un proceso de validación de respuestas interno llevado a cabo por un equipo de lingüistas computacionales del IIC. Este proceso permite asegurar la corrección de las respuestas según la información y los criterios disponibles. De este modo, garantizamos que el agente no solo ofrece respuestas correctas, sino que también lo hace de manera consistente, eficiente y alineada con los estándares de calidad que requiere un entorno corporativo.

Para evaluar el funcionamiento de la plataforma de agentes inteligentes basados en LLM, ha sido clave diseñar estrategias específicas de validación que permitan medir su rendimiento en distintos escenarios. Se han creado conjuntos de test con un proceso de validación de respuestas interno llevado a cabo por un equipo de lingüistas computacionales del IIC. Este proceso permite asegurar la corrección de las respuestas según la información y los criterios disponibles. De este modo, garantizamos que el agente no solo ofrece respuestas correctas, sino que también lo hace de manera consistente, eficiente y alineada con los estándares de calidad que requiere un entorno corporativo.

Para completar esta fase se ha creado una guía detallada sobre cómo realizar las preguntas a la plataforma, para evitar ambigüedad y asegurar que la pregunta esté planteada de la forma más concreta y sencilla posible.

Beneficios de los agentes inteligentes basados en LLM

Más allá de la innovación tecnológica que supone, lo verdaderamente relevante de este caso de uso son los beneficios que aporta.

- Reducción drástica de la complejidad técnica para los usuarios que consumen información de múltiples fuentes.

- Mejora de los tiempos de respuesta ante consultas. Realizar consultas en diversas fuentes de información es un proceso que puede consumir mucho tiempo y recursos. Sin embargo, la solución que se propone reduce el esfuerzo a minutos sin costes de personal.

- Mayor control y gobernanza sobre cómo y cuándo se consultan los diferentes servicios.

- Base sólida para futuras automatizaciones y modelos de inteligencia operacional.